陈清财教授在鹏城实验室名家讲堂做“多跳文本推理”的学术报告

2021年9月26日上午,智能计算研究中心陈清财教授在鹏城实验室名家讲堂做“基于多跳图神经网络的自然语言推理”的学术主题报告,本次报告采用线上线下的方式进行,将近2000人在线观看了本次报告。报告中陈清财教授主要分享了团队的最新研究成果“Multi-hop Graph Convolutional Network with High-order Chebyshev Approximation for Text Reasoning”(Shuoran Jiang, Qingcai Chen*, Baotian Hu et al. ACL 2021, Oral,Accept Rate: 14.57%)

传统的图网络采用单跳链接,不能建模远距离的复杂因果约束,该成果建立了一个可以学习到多跳链接信息的图神经网络模型,考虑到多跳以后,非直接链接节点大大增加,会引入更多噪音,所以模型采用空间注意力机制来抑制非直接链接节点的影响,模型在多项自然语言推理任务上都取得了新的SOTA结果,具有很好的应用潜力。

报告中回顾了图神经网络的发展历程,及其在自然语言推理场景下各种任务中的应用,如:基于句法依存树的信息抽取、基于实体关系图的问答系统以及基于句法依存类别的情感分析。然后以文本图卷积网络为例,着重分析了其面临的过平滑问题和低效的多跳推理问题。并以智能医学诊疗为例,分析了为什么基于单跳推理的GCN已经难以提供足够的表达能力。

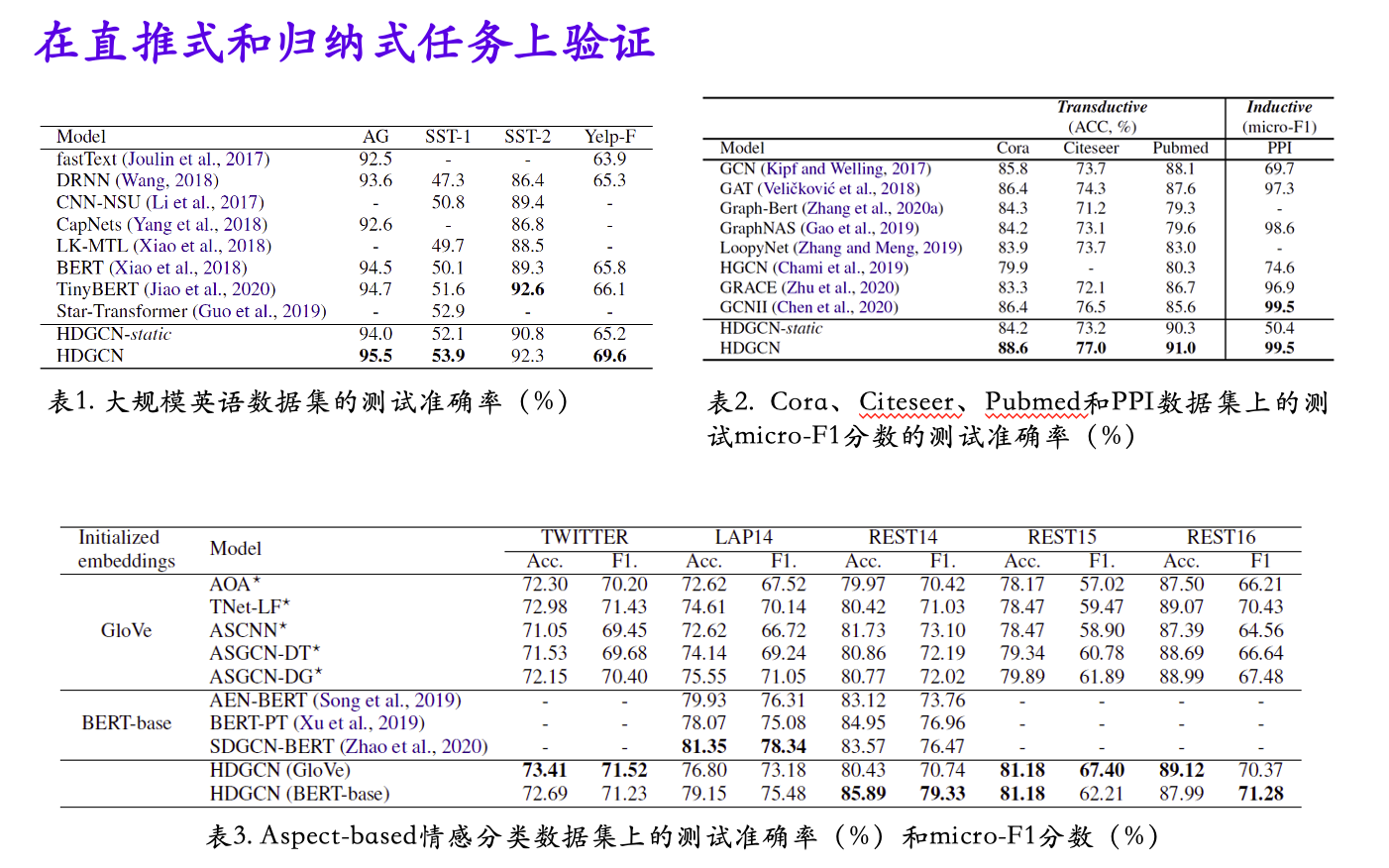

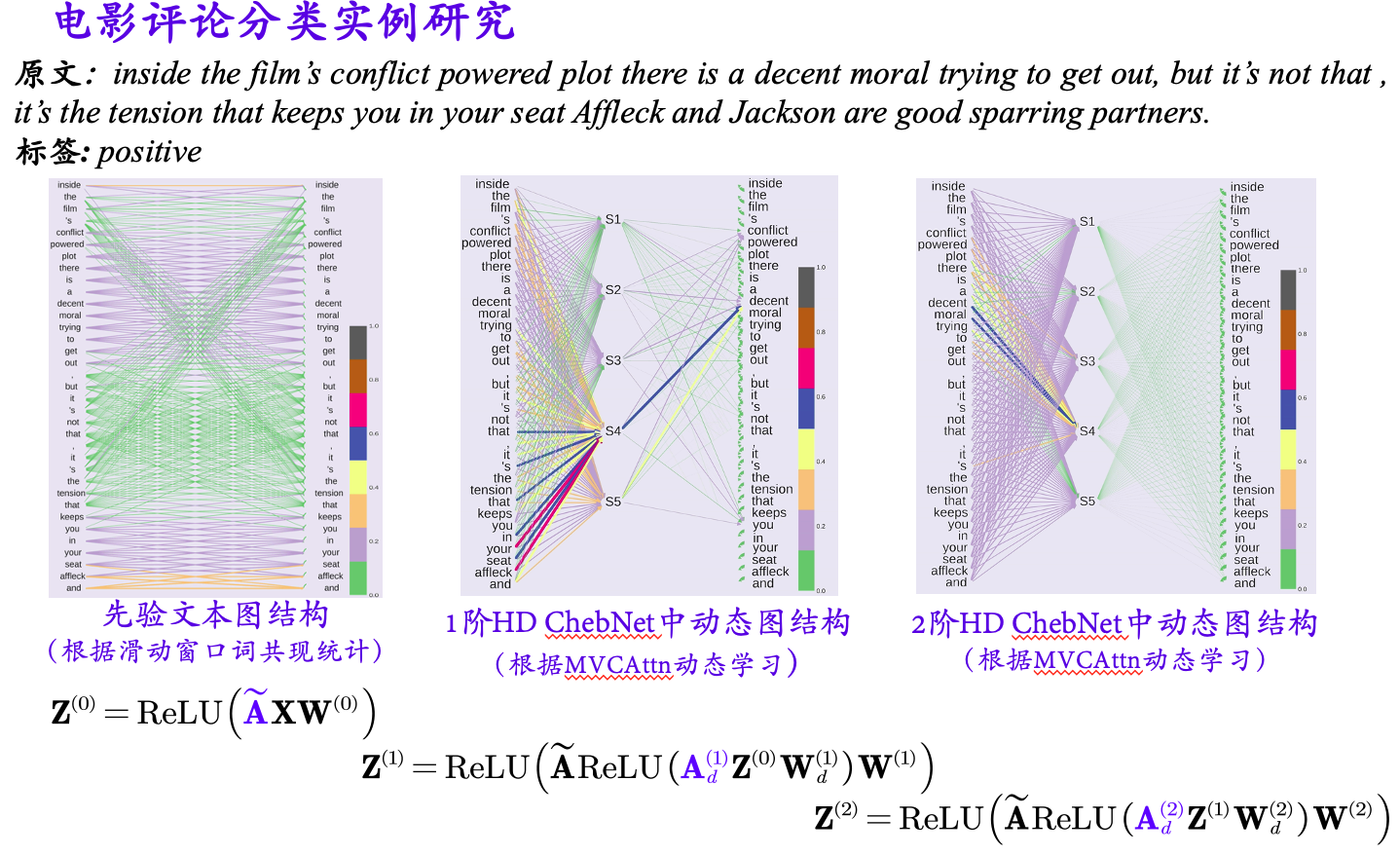

报告随后对多跳图卷积网络的动机,以及用高阶动态切比雪夫近似提高图卷积网络对多跳信息推理能力的思路进行了详细介绍。其中,动态图关系学习的机制基于多投票的交叉注意力机制实现,将自注意力机制的指数计算复杂度降低到线性复杂度。最后给出了多跳图卷积网络在文本分类、情感分析、自然语言推理等任务上的有效性。并以实例详细地分析了多跳图卷积网络对推理效率的提高,以及如何在推理过程中缓解过平滑问题。

多跳图神经网络模型结构图

动态图结构实例分析